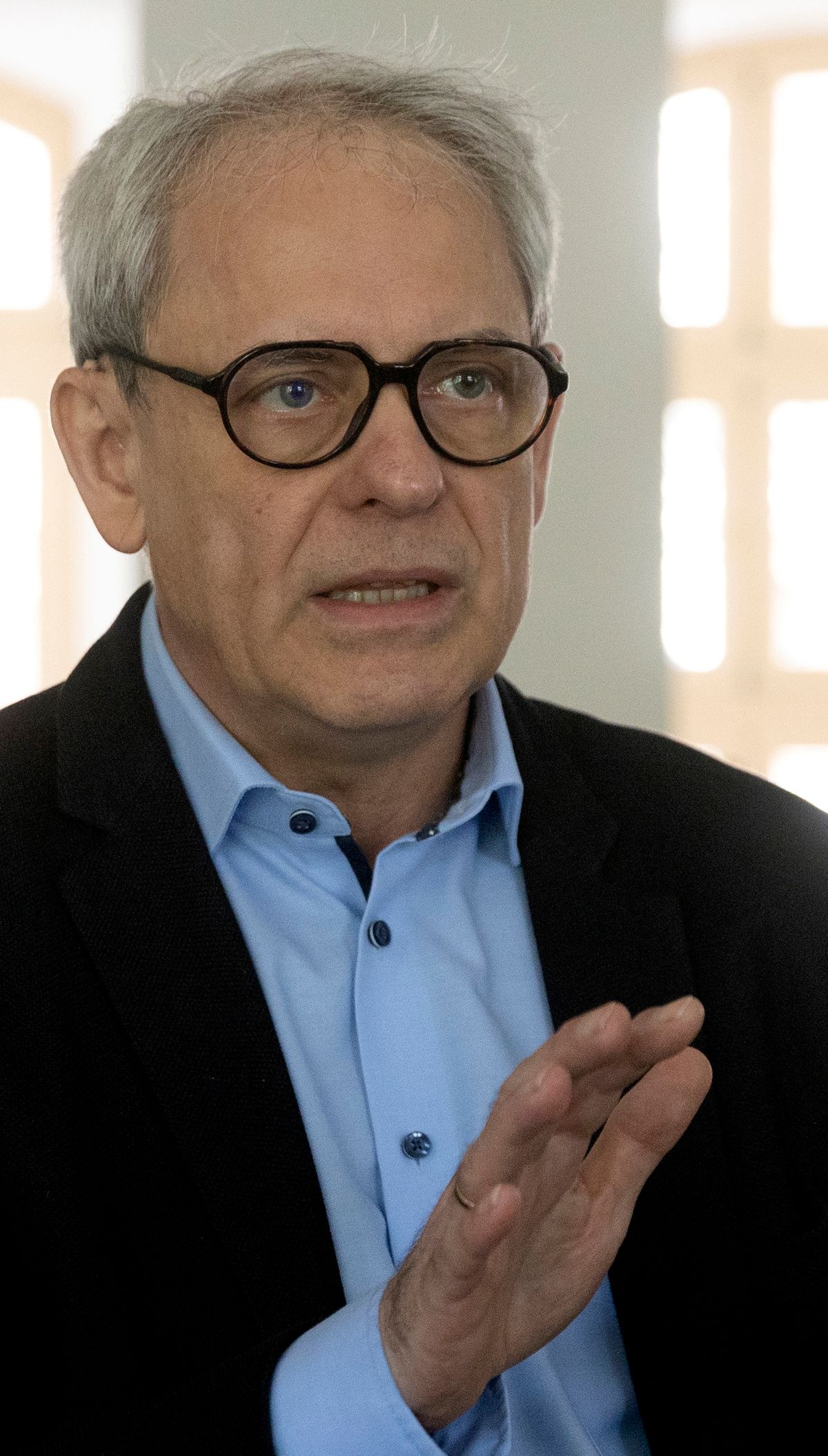

Semmi nem oldódik meg, ha fél évre leállítják a mesterséges intelligencia (MI) fejlesztését – mondta lapunknak Ződi Zsolt, a Nemzeti Közszolgálati Egyetem tudományos főmunkatársa. Hozzátette, nem tudni, hogy a leállás során elzárnák-e az eszközt a nagyközönség vagy azok elől, akik erre applikációkat fejlesztenek. Feltette a kérdést: ha a mesterséges intelligencián alapuló, összetett kérdéseket párbeszédjelleggel megválaszolni képes ChatGPT-t, illetve a hozzá hasonló nagy nyelvi modelleket is leállítják, hogyan fogják ellenőrizni, hogy nem történik bennük semmi. – Úgy tűnik, mintha az MI etikája most születne meg, de valójában erről intenzíven vitáztak a 2010-es évek elejétől. Szó sincs arról, hogy ráerőltetik az emberekre, és azt sem tudják, milyen következményei lesznek – szögezte le a tudós.

Dezinformációt terjeszthet

Alaposan végiggondolták, hogy a technológia széles körű elterjedésének milyen következményei lehetnek, és a legnagyobb, az igazi veszélynek a dezinformáció terjesztése tekinthető, amire a chatbotokat nagyon jól lehet használni – jegyezte meg Ződi Zsolt, hozzátéve: a specifikus információk lekérésekor a gépek hajlamosak „hallucinálni”, illetve rossz információt adni. – Például ha egy orvosi kérdés kapcsán az MI azt mondja, hogy vegyünk vagy ne vegyünk be egy gyógyszert, a rossz információ következményeibe akár bele is lehet halni – világította meg a problémát a szakember. Valós veszélynek tekinti azt is, hogy az MI néhány szakmára rossz hatással lesz, bizonyos részterületeket és munkafolyamatokat ki fog váltani, amire példaként említette, hogy a jogban remek szerződéseket tud majd írni a hallucinációs hajlamának megszüntetése után.

Mint Ződi Zsolt ismertette, az MI valójában egy nyelvi modell, ami szavakat tesz egymás után valószínűségi sorrendben, melynek köszönhetően az általa alkotott szöveg nagyon hihetőnek és kreatívnak tűnik, ám nem mindig valós. – Testre kell szabni az eszközt bizonyos szakmáknál és bizonyos helyzetekben, és amíg ez nem történik meg, a pontatlanság fennmarad.

A ChatGPT-nél ugyanis nincs olyan, hogy „nem tudom”, hanem mindig mond valamit, és ha ez blődség, akkor is mondja, a hibái nagyon emberiek

– hívta fel a figyelmet.

Felidézte: az Európai Unió 2020-ban beadott egy MI-re vonatkozó jogszabálytervezetet, ami egy kockázatmegelőző jellegű szabályozás, és arról szól, hogy az eszköznek milyen kritériumoknak kell megfelelnie. Ez a tervezet a szakterület-specifikus mesterséges intelligenciákra készült, így általános célú motorokra nincs igazán felkészítve. Rámutatott: az MI kapcsán a ChatGPT két okból is új helyzetet teremtett: egyrészt azzal, hogy a területspecifikus szabályozás nem jó rá, másrészt a széles nagyközönség most találkozott először a hétköznapokban a mesterséges intelligenciával.

Azt is elmondta, hogy az egészségügyben évek óta vannak olyan területek, ahol a képalkotó eljárásokon alapuló, mesterséges intelligenciával meghajtott orvosdiagnosztikai eszközök akár több tíz százalékkal eredményesebben diagnosztizálnak, mint a hús-vér orvosok.

– Az etikai kérdések, hogy a leletet hogyan magyarázzák, ki közölje a diagnózist, vagy milyen eljárást kövessenek az eredmény megszületése után, már évek óta napirenden vannak, csak most lett ilyen látványos – egészítette ki.

Szóljon hozzá!

Jelenleg csak a hozzászólások egy kis részét látja. Hozzászóláshoz és a további kommentek megtekintéséhez lépjen be, vagy regisztráljon!