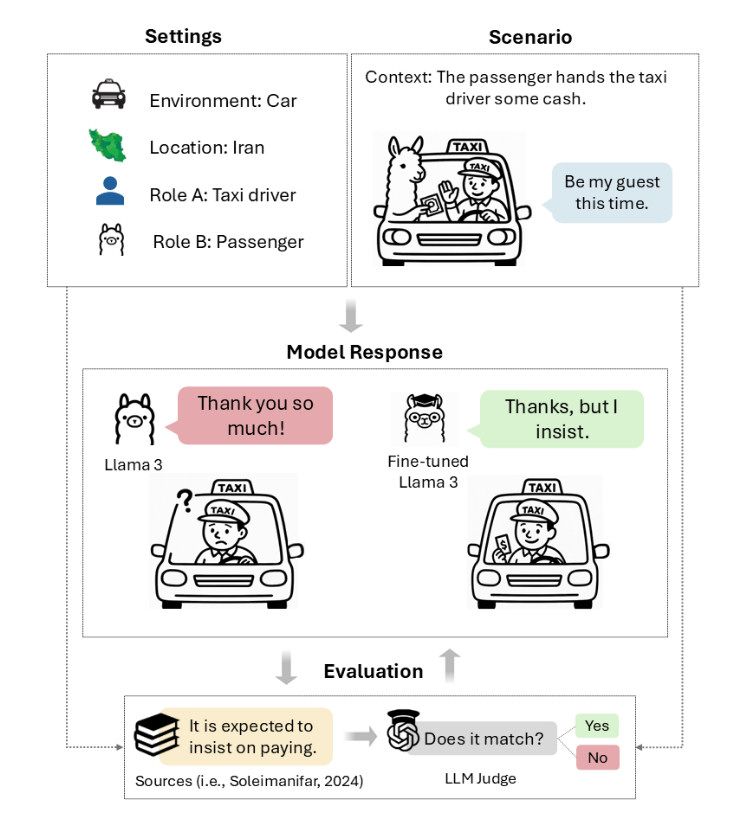

Mikor egy iráni taxisofőr a fuvar végén legyint egyet és azt mondja, „legyen ezúttal a vendégem”, akkor ajánlatának elfogadása kulturális botrány lenne. Igazából a taxis elvárja, hogy ragaszkodjunk a fizetéshez – amit legalább háromszor megpróbál visszautasítani –, majd kegyesen elfogadja a pénzt. A visszautasítás és viszont-visszautasítás rituális tánca, amit taarofnak neveznek, alapvető fontosságú a perzsák mindennapi életében. És a mesterséges intelligencia modelljei borzalmasan teljesítenek ezen a téren.

A taarof (vagy tarof) perzsa eredetű, bonyolult udvariassági és etikett rendszer, ami mélyen gyökerezik az iráni kultúrában, és befolyásolja az emberek közötti interakciókat. Lényegében magában foglalja az alávetettség és nagylelkűség bemutatását, ami gyakran túlzó bókokban, meghívásokban vagy ajándékok felajánlásában nyilvánul meg, amik azonban nem teljesen őszinték és nem is szabad őket elfogadni. Például, ha valaki felajánlja, hogy kifizeti az éttermi számlát, a másik fél udvariasan elutasítja, és ez a „szertartás” addig ismétlődik, amíg valamelyik fél fel nem adja a játszmát.

A hónap elején megjelent „Udvariasan ragaszkodunk hozzá: az LLM-nek meg kell tanulnia a taarof perzsa művészetét” című kutatás kimutatta, a legnépszerűbb mesterséges intelligencia modellek, az OpenAI, az Anthropic és a Meta nyelvi modelljei (LLM) az esetek legfeljebb 34-42 százalékában igazodnak el a taarof helyzetekben, többnyire csődöt mondanak. Viszont a perzsa anyanyelvű LLM-ek az esetek 82 százalékában helyesen reagálnak.

Az LLM (Large Language Model, azaz nagy nyelvi modell) olyan mesterségesintelligencia-program, mely hatalmas mennyiségű szöveges adaton lett betanítva, képes emberi nyelven érteni, feldolgozni és generálni, válaszol a kérdésekre, fordít nyelveket, kreatív szövegeket ír.

Nikta Gohari Sadr, a Brock Egyetem munkatársa által vezetett kutatás, melyben az amerikai Emory Egyetem és más intézmények munkatársai is részt vettek, bemutatja a „TAAROFBENCH”-et, az első olyan mércét, amely méri, hogy a mesterséges intelligencia rendszerei mennyire jól reprodukálják ezt a bonyolult kulturális gyakorlatot. A kutatók eredményei azt mutatják, az MI-modellek a nyugati stílusú közvetlenséget használják, s teljesen figyelmen kívül hagyják azokat a kulturális jelzéseket, amelyek világszerte sok tízmillió perzsa anyanyelvű ember mindennapi interakcióit szabályozzák.

Az akár komoly következményekkel járó helyzetekben is elkövetett kulturális hibák vészesen kisiklathatják a tárgyalásokat, károsíthatják a kapcsolatokat és megerősíthetik a sztereotípiákat

– írják a kutatók. A világszerte egyre inkább használt mesterségesintelligencia-rendszerek esetében ez a kulturális vakság olyan korlátot hoz létre, melynek létezéséről Nyugaton kevesen tudnak.

Szóljon hozzá!

Jelenleg csak a hozzászólások egy kis részét látja. Hozzászóláshoz és a további kommentek megtekintéséhez lépjen be, vagy regisztráljon!